Enquanto muitos cientistas de dados focam obsessivamente em métricas de desempenho como acurácia e precisão, um fenômeno sutil corrói silenciosamente o potencial de seus modelos de aprendizado de máquina. Você já se perguntou por que seu modelo de underfitting e overfitting falha ao tentar prever novos dados, mesmo apresentando resultados impressionantes durante o treinamento? A resposta pode estar em um dos maiores desafios na criação de modelos preditivos robustos.

Imagine construir uma casa: usando pouquíssimos materiais, ela desmorona (underfitting); usando materiais em excesso e detalhes desnecessários, ela se torna instável e cara (overfitting). O mesmo princípio se aplica a modelos de machine learning – encontrar o equilíbrio perfeito é uma arte que poucos dominam, mas que pode ser a diferença entre o sucesso e o fracasso de um projeto de dados.

O problema do underfitting e overfitting representa o verdadeiro teste para qualquer cientista de dados: criar modelos que capturem os padrões essenciais dos dados, ignorando o ruído irrelevante, enquanto permanecem flexíveis o suficiente para generalizar corretamente para novos casos.

Desde os primórdios do aprendizado de máquina na década de 1950, pesquisadores têm lutado com esta dualidade fundamental. Com o avanço da capacidade computacional e a explosão de dados nas últimas décadas, o desafio tornou-se ainda mais proeminente.

Hoje, com modelos cada vez mais complexos sendo implementados em setores críticos como saúde, finanças e transporte autônomo, entender e mitigar os efeitos de underfitting e overfitting tornou-se não apenas uma questão técnica, mas também uma necessidade prática com implicações significativas para negócios e sociedade.

Entendendo o Underfitting e Overfitting: Conceitos Fundamentais

Para compreendermos profundamente estes fenômenos, precisamos primeiro definir claramente o que cada um representa no contexto de machine learning. Ambos são problemas de adequação do modelo aos dados, mas ocorrem em extremos opostos do espectro de complexidade.

O que é Underfitting?

Underfitting ocorre quando um modelo é excessivamente simplista para capturar a estrutura subjacente dos dados. É como tentar explicar um fenômeno complexo com uma regra extremamente básica. Quando um modelo sofre de underfitting:

- Apresenta alto erro tanto nos dados de treinamento quanto nos dados de teste

- Falha em capturar padrões importantes e relações entre variáveis

- Possui baixa capacidade preditiva mesmo para os exemplos já vistos

- Demonstra alta tendenciosidade (viés) em suas previsões

Um exemplo clássico é tentar ajustar uma linha reta (modelo linear) a dados que claramente seguem uma tendência curvilínea. O modelo simplesmente não possui a capacidade expressiva necessária para representar a verdadeira relação nos dados.

O que é Overfitting?

Por outro lado, overfitting acontece quando um modelo é excessivamente complexo e acaba “decorando” os dados de treinamento em vez de aprender padrões generalizáveis. O modelo captura não apenas as tendências reais nos dados, mas também o ruído aleatório. Quando um modelo sofre de overfitting:

- Apresenta erro muito baixo nos dados de treinamento, mas erro alto nos dados de teste

- Memoriza detalhes específicos dos exemplos de treinamento, incluindo suas anomalias

- Demonstra alta variância nas previsões com pequenas alterações nos dados

- Perde capacidade de generalização para dados nunca vistos

Voltando ao exemplo anterior, seria como ajustar uma curva que passa exatamente por cada ponto dos dados de treinamento, incluindo aqueles que são claramente outliers, resultando em uma função extremamente sinuosa e irregular que falha ao prever novos pontos.

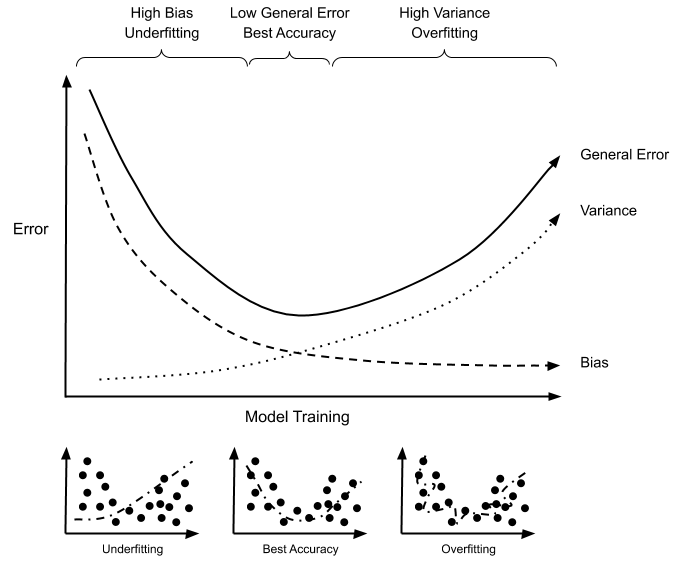

Representação visual de underfitting (à esquerda), ajuste ideal (centro) e overfitting (à direita)

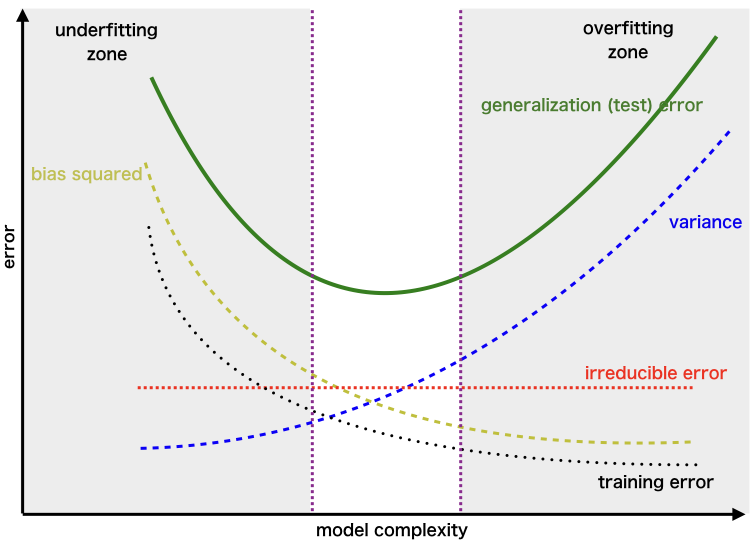

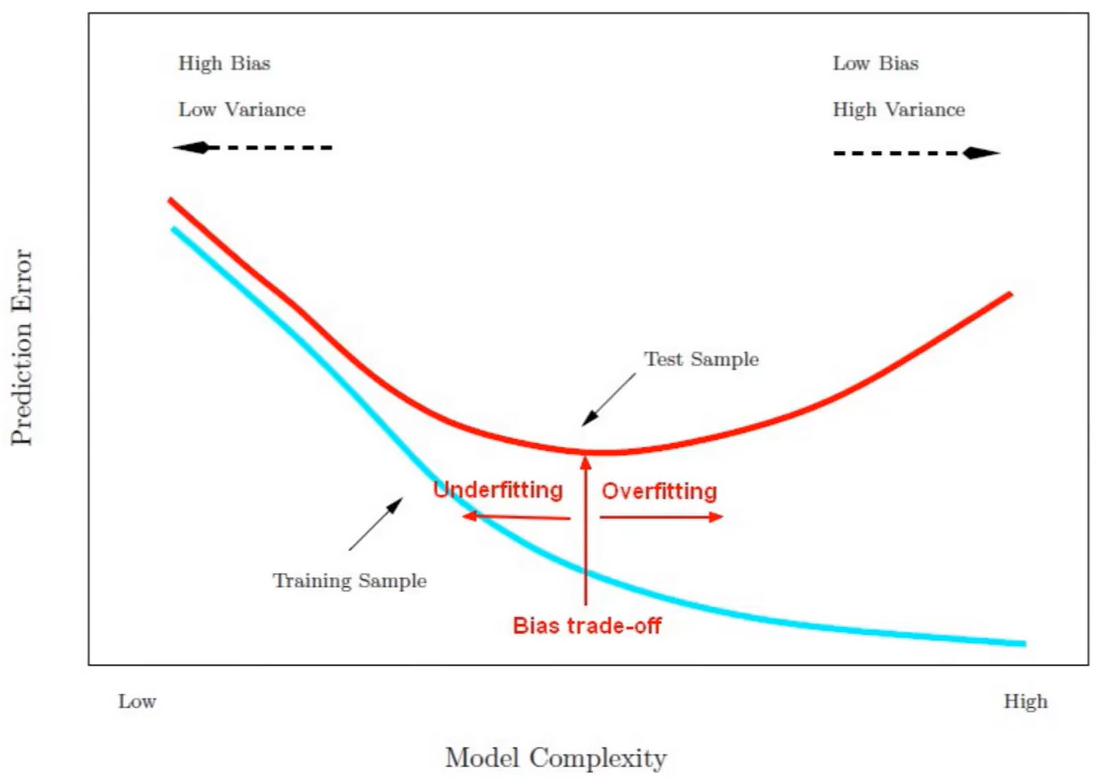

O Dilema Viés-Variância: A Matemática Por Trás do Problema

O equilíbrio entre underfitting e overfitting está diretamente relacionado ao que os estatísticos chamam de dilema viés-variância (bias-variance tradeoff). Este conceito fundamental ajuda a explicar por que encontrar o modelo ideal é tão desafiador.

Entendendo Viés (Bias)

O viés representa o erro introduzido por aproximar um problema real-mundo, que pode ser extremamente complicado, usando um modelo simplificado. É a tendência do modelo de consistentemente errar em uma determinada direção. Alto viés leva a underfitting.

Um modelo com alto viés faz suposições fortes sobre a forma da função alvo, ignorando os dados quando estas suposições estão erradas. Por exemplo, assumir que todos os relacionamentos são lineares quando na verdade são quadráticos.

Entendendo Variância

A variância representa a sensibilidade do modelo a flutuações nos dados de treinamento. É a tendência do modelo de aprender o ruído aleatório ao invés dos padrões subjacentes. Alta variância leva a overfitting.

Um modelo com alta variância captura ruído nos dados de treinamento, resultando em desempenho pobre em dados não vistos anteriormente. Se treinarmos o mesmo modelo em diferentes conjuntos de dados, obteremos resultados significativamente diferentes.

O Tradeoff Inevitável

O dilema viés-variância refere-se ao fato de que não podemos simultaneamente minimizar o viés e a variância. Reduzir um geralmente aumenta o outro. O erro total de um modelo pode ser decomposto em três componentes:

Erro Total = Viés² + Variância + Erro Irredutível

Onde:

- Viés²: Indica quanto as previsões do modelo se desviam sistematicamente dos valores reais

- Variância: Indica quanto as previsões do modelo flutuam para diferentes conjuntos de treinamento

- Erro Irredutível: Representa o ruído inerente ao problema que nenhum modelo pode eliminar

Dilema Viés-Variância: Conforme a complexidade do modelo aumenta, o viés diminui e a variância aumenta

À medida que aumentamos a complexidade de um modelo:

- O viés tende a diminuir (o modelo se torna mais flexível para se ajustar aos dados)

- A variância tende a aumentar (o modelo se torna mais sensível às particularidades dos dados de treinamento)

O desafio central do aprendizado de máquina é encontrar o ponto doce de complexidade do modelo que minimiza o erro total, equilibrando adequadamente viés e variância.

Causas Comuns de Underfitting e Overfitting

Fatores que Contribuem para o Underfitting

- Modelo excessivamente simplista: Escolher um algoritmo com capacidade expressiva insuficiente para capturar a complexidade dos dados

- Recursos insuficientes: Não incluir variáveis preditivas importantes que influenciam significativamente o resultado

- Regularização excessiva: Aplicar restrições muito severas ao modelo, limitando sua capacidade de aprendizado

- Treinamento insuficiente: Interromper o treinamento muito cedo, antes que o modelo tenha convergido para uma solução adequada

- Dados altamente ruidosos: Trabalhar com dados onde o sinal é obscurecido por ruído, dificultando a aprendizagem de padrões

Fatores que Contribuem para o Overfitting

- Modelo excessivamente complexo: Utilizar um algoritmo com muitos parâmetros em relação à quantidade de dados disponíveis

- Conjunto de treinamento pequeno: Treinar com poucos exemplos, fazendo com que o modelo memorize casos específicos

- Treinamento excessivo: Continuar o treinamento por muitas iterações, permitindo que o modelo se ajuste cada vez mais ao ruído

- Falta de regularização: Não impor restrições à complexidade do modelo durante o treinamento

- Excesso de engenharia de recursos: Criar muitas características derivadas sem critério adequado de seleção

- Presença de outliers não tratados: Permitir que valores extremos influenciem indevidamente a aprendizagem do modelo

Exemplos Reais de Underfitting e Overfitting em Diversos Contextos

Para compreender melhor estes conceitos, vamos analisar como eles se manifestam em cenários práticos e diversos setores.

Exemplos de Underfitting no Mundo Real

Sistemas de Recomendação Simplistas: Uma plataforma de streaming que recomenda apenas conteúdo baseado em gêneros amplos, ignorando preferências mais específicas dos usuários, demografia e histórico detalhado de visualização. Usuários da França recebendo as mesmas recomendações que usuários do Japão, apesar de claras diferenças culturais nas preferências.

Previsão de Demanda Linear: Uma empresa varejista espanhola usava um modelo linear simples para prever vendas futuras, considerando apenas tendências temporais básicas. O modelo falhou consistentemente em capturar padrões sazonais complexos e a influência de eventos especiais como feriados e promoções, resultando em grandes erros de estoque.

Diagnóstico Médico Rudimentar: Um sistema automatizado de diagnóstico na Alemanha que utiliza apenas algumas variáveis básicas (como temperatura e pressão arterial) para detectar condições complexas como doenças cardíacas, ignorando fatores importantes como histórico familiar, hábitos de vida e marcadores bioquímicos específicos.

Exemplos de Overfitting no Mundo Real

Caso Fukushima: Um dos exemplos mais impactantes de overfitting ocorreu na análise de risco sísmico da usina nuclear de Fukushima. Os modelos utilizados para prever terremotos foram treinados com dados históricos limitados e acabaram ajustando-se excessivamente a esses dados, subestimando significativamente a probabilidade de um megaterremoto. Quando o terremoto e tsunami de 2011 ocorreram, a magnitude do evento estava muito além do que os modelos haviam previsto como possível.

Assistente de Voz com Reconhecimento Limitado: Um assistente de voz desenvolvido na Suécia que funciona perfeitamente para os sotaques e expressões específicas das pessoas que participaram do conjunto de treinamento, mas falha completamente ao reconhecer comandos semelhantes ditos por pessoas com sotaques diferentes ou formas alternativas de expressar as mesmas intenções.

Trading Algorítmico Hiperparametrizado: Uma empresa de investimentos suíça desenvolveu um algoritmo de trading que gerou retornos extraordinários em backtest histórico, mas falhou catastroficamente quando implantado em mercados reais. O algoritmo havia detectado padrões específicos que ocorreram por coincidência no período de treinamento, levando a uma falsa confiança em sua capacidade preditiva.

Sistema de Admissão Universitária: Uma universidade australiana implementou um sistema automatizado para prever o sucesso acadêmico dos candidatos. O modelo apresentava 99% de precisão nos dados históricos, mas apenas 55% de acurácia com novos candidatos. Investigação posterior mostrou que o modelo havia se ajustado a características específicas da população histórica que não eram mais relevantes para os novos candidatos.

Técnicas para Combater o Underfitting

Combater o underfitting requer estratégias que aumentem a capacidade do modelo de capturar relações complexas nos dados. Vejamos as abordagens mais eficazes:

1. Aumentar a Complexidade do Modelo

A solução mais direta para o underfitting é utilizar um modelo com maior capacidade expressiva:

- Substituir modelos lineares por modelos não-lineares (árvores de decisão, redes neurais)

- Aumentar a profundidade das redes neurais ou o número de estimadores em modelos ensemble

- Incluir termos polinomiais ou interações entre características

2. Enriquecimento de Features

Amplie o conjunto de características para capturar melhor as nuances dos dados:

- Criar novas características baseadas no conhecimento de domínio

- Aplicar transformações não-lineares às características existentes

- Utilizar técnicas de extração automática de características, como redes neurais convolucionais para dados de imagem

3. Redução de Regularização

Se a regularização estiver muito forte, ela pode estar impedindo o modelo de aprender adequadamente:

- Diminuir os valores de parâmetros de regularização (como C em SVM ou alpha em Ridge/Lasso)

- Reduzir a taxa de dropout em redes neurais

- Revisar outras penalidades que possam estar limitando a capacidade do modelo

4. Treinamento Mais Intensivo

Garantir que o modelo tenha oportunidade suficiente para aprender:

- Aumentar o número de épocas ou iterações de treinamento

- Ajustar taxas de aprendizado para permitir convergência adequada

- Experimentar diferentes otimizadores que possam escapar de mínimos locais

5. Tratamento de Dados

Melhorar a qualidade dos dados de entrada:

- Normalizar ou padronizar características para facilitar o aprendizado

- Identificar e corrigir valores ausentes com métodos mais sofisticados

- Realizar limpeza de ruído que possa estar obscurecendo padrões importantes

Dica prática: Ao combater o underfitting, comece aumentando gradualmente a complexidade do modelo e monitore tanto o desempenho no conjunto de treinamento quanto no conjunto de validação. Se ambos melhorarem em paralelo, você está no caminho certo.

Estratégias Eficazes para Evitar o Overfitting

O overfitting é geralmente mais comum e problemático que o underfitting. Felizmente, existem diversas técnicas comprovadas para mitigá-lo:

1. Técnicas de Regularização

A regularização é uma das estratégias mais poderosas para prevenir overfitting:

- Regularização L1 (Lasso): Adiciona uma penalidade proporcional ao valor absoluto dos pesos, induzindo esparsidade

- Regularização L2 (Ridge): Adiciona uma penalidade proporcional ao quadrado dos pesos, impedindo que cresçam excessivamente

- Elastic Net: Combina as regularizações L1 e L2 para obter os benefícios de ambas

- Dropout: Em redes neurais, desativa aleatoriamente neurônios durante o treinamento, forçando a rede a criar representações mais robustas

- Early Stopping: Interrompe o treinamento quando o desempenho no conjunto de validação começa a deteriorar

2. Validação Cruzada

Utilize técnicas robustas de validação para melhor estimar o desempenho real do modelo:

- K-fold Cross-Validation: Divide os dados em k partes, treinando k modelos diferentes usando k-1 partes para treino e a parte restante para validação

- Validação Cruzada Estratificada: Mantém a proporção das classes em cada fold, importante para dados desbalanceados

- Leave-One-Out Cross-Validation: Útil para conjuntos de dados pequenos, treina em todos os exemplos menos um, validando no exemplo deixado de fora

3. Aumento de Dados (Data Augmentation)

Aumente efetivamente o tamanho do conjunto de treinamento:

- Para imagens: rotações, espelhamentos, cortes, alterações de brilho e contraste

- Para texto: substituições de sinônimos, alteração da ordem das palavras, traduções

- Para séries temporais: adição de ruído, deslocamentos temporais, mudanças de escala

4. Simplificação do Modelo

Reduza a complexidade para limitar a capacidade do modelo de memorizar o ruído:

- Reduzir o número de camadas ou unidades em redes neurais

- Limitar a profundidade máxima de árvores de decisão

- Usar modelos mais simples quando apropriado (ex: regressão linear vs. redes neurais complexas)

5. Ensemble Learning

Combine múltiplos modelos para reduzir a variância:

- Bagging: Treina múltiplos modelos em diferentes subconjuntos do conjunto de treinamento (ex: Random Forest)

- Boosting: Treina modelos sequencialmente, cada um focando nos erros dos anteriores (ex: XGBoost, AdaBoost)

- Stacking: Combina previsões de diferentes tipos de modelos usando um meta-modelo

6. Poda de Recursos (Feature Selection)

Reduza dimensionalidade para focar apenas em características verdadeiramente relevantes:

- Métodos baseados em filtro (correlação, informação mútua)

- Métodos wrapper (seleção recursiva de características)

- Métodos incorporados (regularização L1, importância de características em árvores)

- Técnicas de redução de dimensionalidade (PCA, t-SNE, autoencoders)

Efeito da regularização na redução do overfitting, suavizando a fronteira de decisão

Comparação: Underfitting vs Overfitting

Para facilitar a compreensão das diferenças fundamentais entre underfitting e overfitting, observe a tabela comparativa a seguir:

| Característica | Underfitting | Ajuste Ideal | Overfitting |

|---|---|---|---|

| Erro no treino | Alto | Moderado | Muito baixo |

| Erro no teste | Alto | Baixo | Alto |

| Complexidade do modelo | Muito simples | Adequada | Excessivamente complexa |

| Viés (Bias) | Alto | Baixo | Muito baixo |

| Variância | Baixa | Baixa | Alta |

| Capacidade de generalização | Fraca (simplista) | Excelente | Fraca (memorização) |

| Causas comuns | Modelo muito simples; poucos recursos; regularização excessiva | Equilíbrio entre complexidade e generalização | Modelo muito complexo; conjunto de treino pequeno; ruído nos dados |

| Soluções típicas | Aumentar complexidade; adicionar recursos; reduzir regularização | Validação cruzada; monitoramento regular | Regularização; mais dados; simplificação do modelo; early stopping |

Prós de Modelos Mais Simples

- Maior interpretabilidade

- Treinamento mais rápido

- Menos propensos a overfitting

- Menores requisitos computacionais

- Mais fáceis de debugar e manter

Prós de Modelos Mais Complexos

- Capacidade de capturar relações não-lineares

- Melhor desempenho em problemas sofisticados

- Menor necessidade de engenharia manual de recursos

- Adaptabilidade a diversos tipos de dados

- Potencial para descobrir padrões sutis

Encontrando o Equilíbrio: O Processo Prático

Encontrar o ponto ideal entre underfitting e overfitting não é um processo único, mas um fluxo de trabalho iterativo que requer atenção meticulosa e experimentação. Veja como profissionais experientes abordam este desafio:

1. Estabeleça uma Linha de Base Clara

Comece com um modelo simples para estabelecer um desempenho de referência. Isso ajuda a compreender o nível mínimo de complexidade necessária e fornece um ponto de comparação para modelos mais sofisticados.

2. Divida os Dados Adequadamente

Use uma estratégia robusta de divisão de dados, tipicamente:

- 60-70% para treinamento

- 15-20% para validação (ajuste de hiperparâmetros)

- 15-20% para teste (avaliação final)

3. Implementação de Validação Cruzada

Utilize k-fold cross-validation para obter estimativas mais robustas do desempenho do modelo, especialmente em conjuntos de dados menores. Isso reduz a chance de tirar conclusões baseadas em uma divisão específica dos dados.

4. Aumente a Complexidade Gradualmente

Em vez de saltar diretamente para modelos altamente complexos:

- Comece com modelos simples e aumente gradualmente a complexidade

- Monitore simultaneamente o erro de treinamento e validação

- Pare de aumentar a complexidade quando o desempenho da validação começar a deteriorar

5. Curvas de Aprendizado

Analise curvas de aprendizado para diagnosticar problemas de ajuste:

- Plote o erro de treinamento e validação em função do tamanho do conjunto de treinamento

- Se ambas as curvas convergem para um erro alto: underfitting (modelo muito simples)

- Se o erro de treinamento é muito menor que o de validação: overfitting (modelo muito complexo)

- Se as curvas convergem para um erro baixo: ajuste adequado

6. Busca Sistemática de Hiperparâmetros

Utilize métodos como Grid Search, Random Search ou otimização bayesiana para encontrar os melhores hiperparâmetros de maneira sistemática, sempre validando em dados não vistos durante o treinamento.

7. Regularização Adaptativa

Em vez de usar valores fixos para parâmetros de regularização:

- Comece com regularização moderada

- Ajuste os parâmetros com base no desempenho de validação

- Considere regularização adaptativa que se ajusta durante o treinamento

8. Combine Técnicas Complementares

As melhores soluções geralmente envolvem uma combinação de abordagens:

- Engenharia de recursos + regularização

- Validação cruzada + early stopping

- Ensembles de modelos com diferentes níveis de complexidade

Curvas de aprendizado para diagnóstico de problemas de fitting: (a) underfitting, (b) overfitting, (c) ajuste adequado

Encontrar o equilíbrio perfeito entre underfitting e overfitting é como afinar um instrumento musical. Requer precisão, paciência e uma compreensão profunda tanto do instrumento quanto da música que se pretende tocar.

Além do Básico: Técnicas Avançadas para o Equilíbrio Viés-Variância

Para cientistas de dados e engenheiros de machine learning que buscam excelência, existem abordagens mais sofisticadas para gerenciar o equilíbrio viés-variância:

Transfer Learning e Modelos Pré-treinados

Utilize modelos pré-treinados em grandes conjuntos de dados e faça fine-tuning apenas nas camadas finais para seu problema específico. Esta estratégia combina o poder de modelos complexos com a capacidade de generalização aprendida de grandes volumes de dados diversos.

Arquiteturas com Balanceamento Interno

Algumas arquiteturas de modelo foram especificamente projetadas para mitigar overfitting, como:

- Redes residuais (ResNet) que facilitam o treinamento de modelos muito profundos sem overfitting

- Arquiteturas com bottleneck que forçam o modelo a aprender representações compactas

- Modelos com atenção que focam apenas em partes relevantes dos dados

Meta-learning e AutoML

Sistemas de meta-aprendizado e AutoML podem automaticamente encontrar arquiteturas e hiperparâmetros que otimizam o equilíbrio entre viés e variância, explorando sistematicamente o espaço de configurações possíveis.

Aprendizado Multi-tarefa

Treinar um modelo para realizar múltiplas tarefas relacionadas simultaneamente pode melhorar a generalização, pois força o modelo a aprender representações que funcionam bem para diferentes objetivos, reduzindo o risco de overfitting a uma única tarefa.

Calibração de Modelo

Além de otimizar para precisão preditiva, calibre seus modelos para fornecer estimativas probabilísticas bem calibradas. Isso ajuda a identificar quando o modelo está “confiante demais” devido ao overfitting.

Conclusão: Dominando a Arte do Equilíbrio em Machine Learning

O desafio de navegar entre underfitting e overfitting representa a essência da ciência de dados aplicada. Não é apenas um problema técnico, mas uma arte que requer intuição, experiência e rigor metodológico. O dilema viés-variância não é um obstáculo a ser superado, mas sim uma realidade fundamental com a qual precisamos trabalhar constantemente.

Os modelos mais eficazes não são necessariamente os mais complexos ou os mais simples, mas aqueles que capturam adequadamente a estrutura inerente dos dados sem se deixar enganar pelo ruído. Como vimos ao longo deste artigo, existem inúmeras técnicas para encontrar esse equilíbrio delicado, desde métodos clássicos como regularização e validação cruzada até abordagens avançadas como ensembles e aprendizado multi-tarefa.

O verdadeiro domínio vem da capacidade de diagnosticar corretamente o problema (underfitting ou overfitting) e aplicar as técnicas apropriadas no contexto específico. Isso requer não apenas conhecimento teórico dos algoritmos, mas também familiaridade com o domínio do problema e os dados em questão.

A jornada para construir modelos equilibrados nunca termina realmente. À medida que os dados evoluem, as relações mudam e surgem novos desafios, o processo de refinamento continua. Os profissionais mais bem-sucedidos neste campo são aqueles que abraçam essa natureza iterativa e estão constantemente aprendendo, ajustando e refinando suas abordagens.

Em última análise, underfitting e overfitting não são apenas conceitos teóricos confinados ao mundo acadêmico. Eles têm impactos profundos em aplicações do mundo real, desde sistemas de recomendação até diagnósticos médicos e análises de risco. Dominar seu equilíbrio não é apenas uma questão de métricas de desempenho, mas de criar soluções de IA que sejam verdadeiramente confiáveis, robustas e valiosas para a sociedade.

Perguntas Frequentes sobre Underfitting e Overfitting

Como posso saber rapidamente se meu modelo está sofrendo de underfitting ou overfitting?

O indicador mais direto é comparar o desempenho nos conjuntos de treinamento e teste. Se ambos têm desempenho ruim, você provavelmente está com underfitting. Se o desempenho é excelente no treinamento mas significativamente pior no teste, você está com overfitting. Também é útil analisar curvas de aprendizado e verificar a complexidade do modelo em relação ao tamanho do conjunto de dados.

É possível ter simultaneamente underfitting e overfitting em diferentes partes do mesmo modelo?

Sim, especialmente em modelos complexos como redes neurais profundas. Algumas partes da rede podem estar superajustadas (overfitting) a características específicas dos dados de treinamento, enquanto outras partes podem estar subajustadas (underfitting), não captando padrões importantes. Técnicas como regularização por camada e congelamento seletivo de parâmetros podem ajudar a lidar com este cenário.

Qual é mais prejudicial para aplicações práticas: underfitting ou overfitting?

Ambos são prejudiciais, mas o impacto varia conforme o contexto. O overfitting geralmente é mais comum e pode ser enganoso porque cria uma falsa confiança baseada em métricas de treinamento excelentes. No entanto, em aplicações onde o custo de falsos negativos é extremamente alto (como detecção de doenças), o underfitting pode ser mais prejudicial por perder padrões importantes nos dados.

Como o tamanho do conjunto de dados afeta o risco de underfitting e overfitting?

Com conjuntos de dados pequenos, o risco de overfitting aumenta significativamente, pois o modelo pode facilmente memorizar todos os exemplos. À medida que o volume de dados cresce, o risco de overfitting geralmente diminui, permitindo o uso de modelos mais complexos sem perda de generalização. No entanto, mais dados não resolvem o underfitting – para isso, é necessário aumentar a capacidade expressiva do modelo.

As técnicas para combater underfitting e overfitting mudam conforme o tipo de algoritmo de machine learning?

Sim, definitivamente. Por exemplo, em árvores de decisão combatemos overfitting limitando a profundidade máxima ou exigindo um número mínimo de amostras por folha. Já em redes neurais, usamos técnicas como dropout e regularização L2. Em modelos lineares, a seleção de características e regularização Ridge/Lasso são abordagens comuns. Cada família de algoritmos tem suas vulnerabilidades específicas e técnicas correspondentes.

Economista e trader veterano especializado em ativos digitais, forex e derivativos. Com mais de 12 anos de experiência, compartilha análises e estratégias práticas para traders que levam o mercado a sério.

Este conteúdo é exclusivamente para fins educacionais e informativos. As informações apresentadas não constituem aconselhamento financeiro, recomendação de investimento ou garantia de retorno. Investimentos em criptomoedas, opções binárias, Forex, ações e outros ativos financeiros envolvem riscos elevados e podem resultar na perda total do capital investido. Sempre faça sua própria pesquisa (DYOR) e consulte um profissional financeiro qualificado antes de tomar qualquer decisão de investimento. Sua responsabilidade financeira começa com informação consciente.

Atualizado em: junho 19, 2025